Nếu bạn muốn chạy các mô hình ngôn ngữ lớn LLM trên máy tính xách tay của mình, việc này chưa bao giờ dễ dàng hơn thế nhờ LM Studio miễn phí và mạnh mẽ.

Các mô hình ngôn ngữ lớn (LLM) như ChatGPT, Google Bard và Bing Chat đều chạy trên đám mây và điều đó về cơ bản có nghĩa là chúng chạy trên máy tính của người khác. Không chỉ vậy, chúng còn đặc biệt tốn kém khi chạy và đó là lý do tại sao ChatGPT có tùy chọn Plus mà bạn có thể đăng ký chẳng hạn. Tuy nhiên, bạn có thể chạy nhiều mô hình ngôn ngữ khác nhau như Llama 2 cục bộ và với sức mạnh của LM Studio, bạn có thể chạy khá nhiều LLM cục bộ một cách dễ dàng.

→Mời bạn tham khảo Cách nâng cấp Chat GPT Plus!

Yêu cầu về cấu hình máy tính của LM Studio

Bạn sẽ chỉ cần một vài thứ để chạy LM Studio:

- Apple Silicon Mac (M1/M2/M3) với macOS 13.6 trở lên

- PC Windows / Linux có bộ xử lý hỗ trợ AVX2 (thường là PC mới hơn)

- Nên sử dụng RAM 16GB+. Đối với PC, nên sử dụng VRAM 6GB+

- Hỗ trợ GPU NVIDIA/AMD

- Kết nối internet (tùy chọn nhanh) để tải xuống mô hình

Nếu bạn có những điều trên thì bạn đã sẵn sàng để đi. Tôi đang sử dụng RTX 4080 với 16GB VRAM và vì đây là một trong những card đồ họa tốt nhất nên quá trình tạo văn bản của tôi rất nhanh chóng.

Hướng dẫn tự chạy các mô hình ngôn ngữ lớn LLM trên máy tính

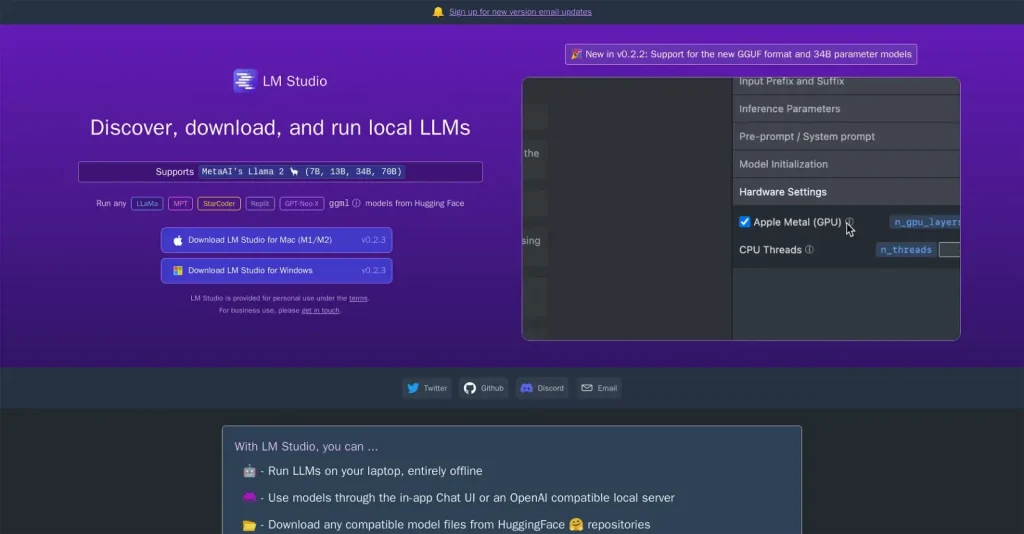

Bước 1: Tải xuống và khởi chạy LM Studio

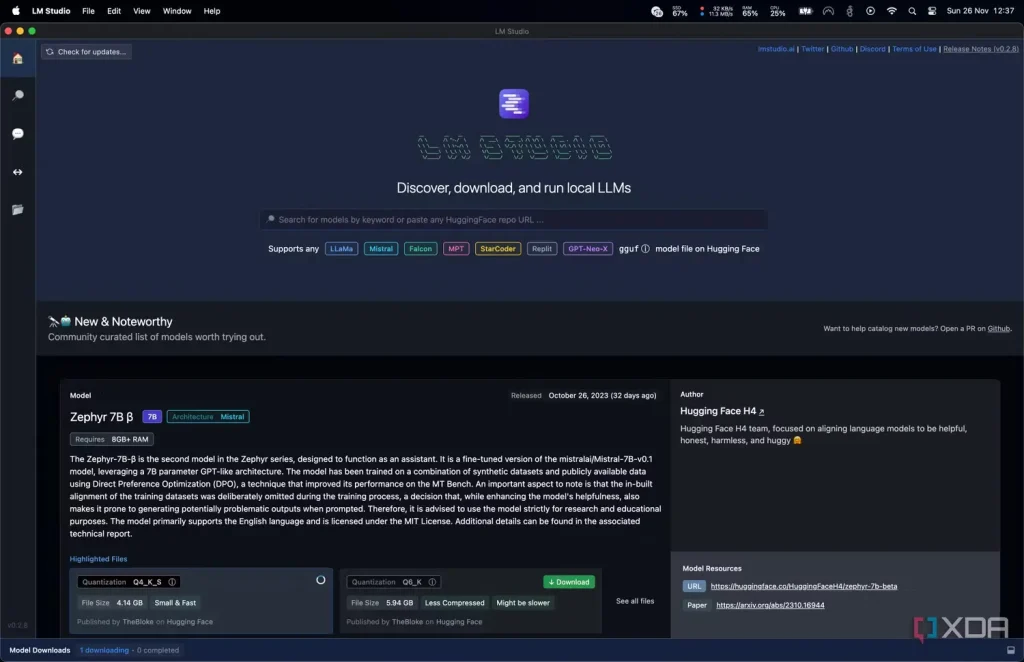

Trước tiên, bạn cần tải xuống LM Studio từ trang chủ cho bất kỳ nền tảng nào bạn đang sử dụng. Quá trình tải xuống này có thể mất một chút thời gian vì nó nặng khoảng 400 MB, tùy thuộc vào tốc độ kết nối Internet của bạn. Sau khi tải xuống, hãy khởi chạy nó và nó sẽ trông giống như ảnh chụp màn hình ở trên.

Bước 2: Chọn model để tải về

Tiếp theo, chọn mô hình (model) để tải xuống bằng cách nhấp vào kính lúp và xem qua các tùy chọn có sẵn. Hầu hết các mô hình này sẽ có kích thước vài gigabyte và có thể mất một lúc để tải xuống. Tôi đang sử dụng Zepyhr-7B vì nó đủ nhỏ và dễ sử dụng cho LLM nhưng có rất nhiều LLM khác nhau để bạn lựa chọn. Hãy duyệt qua, thực hiện một số nghiên cứu và xem liệu có điều gì thu hút sự chú ý của bạn không. Zephyr là mô hình được đào tạo để làm trợ lý nên khi thiết lập sẽ có ích. Khi bạn đã chọn một, hãy làm như sau:

- Đợi nó tải xong.

- Nhấp vào Bong bóng lời nói ở bên trái.

- Ở trên cùng, hãy chọn mô hình của bạn .

- Đợi nó tải.

Bước 3: Bắt đầu sử dụng!

Điều đó thực sự đơn giản và bạn đã tải xuống và thiết lập LLM cục bộ để nói chuyện. Tại thời điểm này, bạn có thể kích hoạt khả năng tăng tốc GPU ở phía bên phải để tăng tốc độ phản hồi nếu muốn, mặc dù điều đó không cần thiết. Tôi chạy LM Studio trên RTX 4080 với 20 lớp GPU, nhưng bạn có thể cần nhiều hơn hoặc ít hơn.

Tại sao nên sử dụng LLM tại máy tính cá nhân?

Nếu bạn đang thắc mắc tại sao bạn lại muốn sử dụng LLM cục bộ thì có một số lý do. Điều đầu tiên và cũng là điều khiến hầu hết mọi người quan tâm là quyền riêng tư. LLM là những công cụ mạnh mẽ có thể được sử dụng cho mục đích tổ chức và lập kế hoạch, một số trong đó có thể có tính chất nhạy cảm. Nếu bạn cũng muốn hỏi LLM về mã riêng tư (ví dụ: nếu bạn đang gỡ lỗi mã đó), thì bạn không bao giờ nên sử dụng mã dựa trên đám mây.

Đây cũng chỉ là bề nổi của các lý do. Đôi khi, các LLM này được điều chỉnh theo các trường hợp sử dụng cụ thể mà Bard, ChatGPT và Bing Chat không thể cung cấp. Như đã đề cập, Zephyr được đào tạo như một trợ lý ảo và mức độ cụ thể đó không có trong các LLM khác. Chắc chắn hãy dùng thử LM Studio nếu bạn muốn dùng thử vì việc chạy LLM của riêng bạn chưa bao giờ dễ dàng hơn thế!