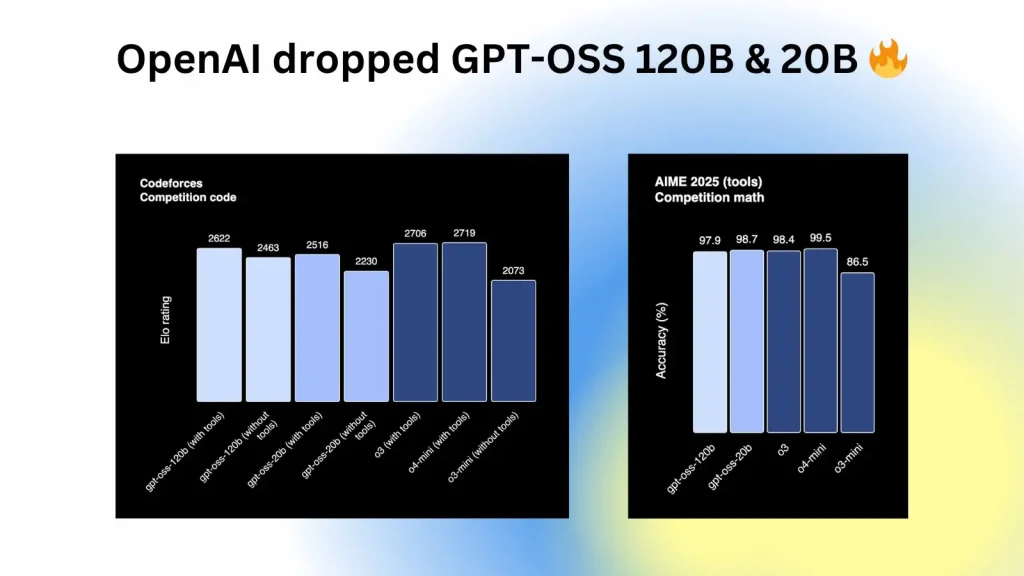

Cuối cùng thì OpenAI cũng công bố gpt-oss, một bộ mô hình mã nguồn mở (open source) với trọng số mở (open weights model) được chia sẻ công khai, mạnh ngang o3 và gần bằng o4-mini. Mô hình gpt-oss là mô hình ngôn ngữ lớn LLM 120 tỷ tham số, hỗ trợ suy luận đa cấp, chain-of-thought, công cụ Python và web search, giấy phép Apache 2.0, miễn phí, và chạy trực tiếp ngay trên laptop hoặc máy chủ web của bạn.

Mô hình GPT-OSS là gì?

OpenAI đang triển khai gpt-oss-120b và gpt-oss-20b – hai mô hình ngôn ngữ tiên tiến có trọng số mở, giúp mang lại hiệu suất thực tế mạnh mẽ với chi phí thấp. Được phát hành theo giấy phép Apache 2.0 linh hoạt, các mô hình này vượt trội hơn so với các open model cùng kích thước trong quá trình thực hiện các nhiệm vụ lập luận, thể hiện khả năng sử dụng công cụ mạnh mẽ, và được tối ưu hóa để triển khai hiệu quả trên phần cứng của người dùng.

Các mô hình gpt-oss được huấn luyện bằng cách học tập tăng cường và kết hợp các kỹ thuật được xây dựng dựa trên các mô hình nội bộ tiên tiến nhất của OpenAI, bao gồm o3 và các hệ thống tiên phong khác.

Cả hai phiên bản mô hình đều đang được phát hành hôm nay thông qua các nền tảng như Hugging Face, Databricks, Azure và AWS theo giấy phép Apache 2.0, cho phép chúng được sửa đổi rộng rãi cho mục đích thương mại.

Mô hình GPT-OSS có gì mạnh?

Mô hình gpt-oss có hai phiên bản: phiên bản 120 tỷ tham số và phiên bản 20 tỷ tham số. Hai mô hình này không chỉ được tối ưu bằng kỹ thuật mixture-of-experts, mà còn hỗ trợ lượng tử hóa 4-bit giúp chạy nhanh hơn nhiều so với mô hình cùng kích thước. Mô hình gpt-oss-20B có thể chạy trực tiếp trên laptop cá nhân với GPU tầm trung hoặc PC có GPU 3090 trở lên, thậm chí là chạy được trên điện cấu hình cao.

Điều khiến gpt-oss trở nên đặc biệt không chỉ nằm ở sức mạnh kỹ thuật, mà ở tính thực tiễn và khả năng kiểm soát cho nhóm đối tượng Doanh nghiệp. Nhiều công ty, nhất là trong lĩnh vực tài chính và nghiên cứu, luôn dè chừng chuyện bảo mật khi gửi dữ liệu lên cloud: họ muốn mô hình mở, nhưng lại ngại cài DeepSeek R1, Kimi K2 hay Qwen vì nguồn gốc Trung Quốc. Giờ thì họ có lựa chọn “made in USA” với giấy phép Apache 2.0, vừa kéo mô hình về data-center riêng, vừa tránh rủi ro địa chính trị. Các công ty nhỏ và nhà sáng tạo độc lập giờ có thể có thể dựng mô hình trong mạng nội bộ, máy cá nhân, tinh chỉnh (fine-tune) trên tập dữ liệu độc quyền, mà không lo về NDAs hay bảo mật dự án.

Ngoài ra, thêm 1 điểm ăn tiền nữa là: OpenAI không đơn thuần chia sẻ trọng số; họ khéo léo giữ khách hàng trong hệ sinh thái khi dùng đúng tokenizer, đúng định dạng prompt, và hỗ trợ chuyển đổi mượt mà giữa mô hình cục bộ và API đám mây. Nghĩa là bạn có thể phát triển ứng dụng offline với gpt-oss, và khi cần mở rộng, chỉ việc thay đường dẫn API là xong, không cần viết lại mã nguồn.

Về mặt an toàn, OpenAI cho biết GPT-OSS là mô hình được kiểm tra nghiêm ngặt nhất từ trước đến nay của họ, và đã được thử nghiệm với các công ty an toàn bên ngoài để đảm bảo không gây ra rủi ro trong các lĩnh vực như an ninh mạng và vũ khí sinh học. Chuỗi suy nghĩ của mô hình, hay quy trình hiển thị được sử dụng để đi đến câu trả lời, được thể hiện “để giám sát hành vi sai trái, lừa dối và lạm dụng mô hình”, theo thông cáo báo chí của công ty. Đầu ra của nó chỉ là văn bản và, giống như tất cả các mô hình của OpenAI, dữ liệu đào tạo của GPT-OSS không được tiết lộ.

Mô hình GPT-OSS có điểm yếu gì?

Tất nhiên, mô hình vẫn có điểm yếu. Trong bảng đánh giá về hallucination (suy diễn sai sự thật), gpt-oss vẫn “ảo giác” hơn các mô hình đầu bảng như o4-mini, nhất là với các câu hỏi đơn giản dạng factual. Nên nếu dùng cho các tác vụ như pháp lý, y tế hay giáo dục, chúng ta vẫn cần layer kiểm tra, hoặc một mô hình phụ để fact-check. Nhưng ít ra, lần này OpenAI đã trao quyền vào tay cộng đồng chúng ta có thể kiểm tra, điều chỉnh, và chịu trách nhiệm với mô hình mình triển khai, thay vì “tin tưởng mù quáng” vào API đóng.

Cấu hình máy tính để chạy GPT-OSS

Hãy đảm bảo hệ thống của bạn đáp ứng các yêu cầu sau:

- Phần cứng:

- Đối với gpt-oss-20b: Tối thiểu 16GB RAM, lý tưởng nhất là có GPU (ví dụ: NVIDIA 1060 4GB).

- Đối với gpt-oss-120b: 80GB bộ nhớ GPU (ví dụ: một GPU 80GB duy nhất hoặc thiết lập trung tâm dữ liệu cao cấp).

- 20-50GB dung lượng lưu trữ trống cho trọng số mô hình và các phụ thuộc.

- Phần mềm:

- Hệ điều hành: Nên dùng Linux hoặc macOS; Windows được hỗ trợ với thiết lập bổ sung.

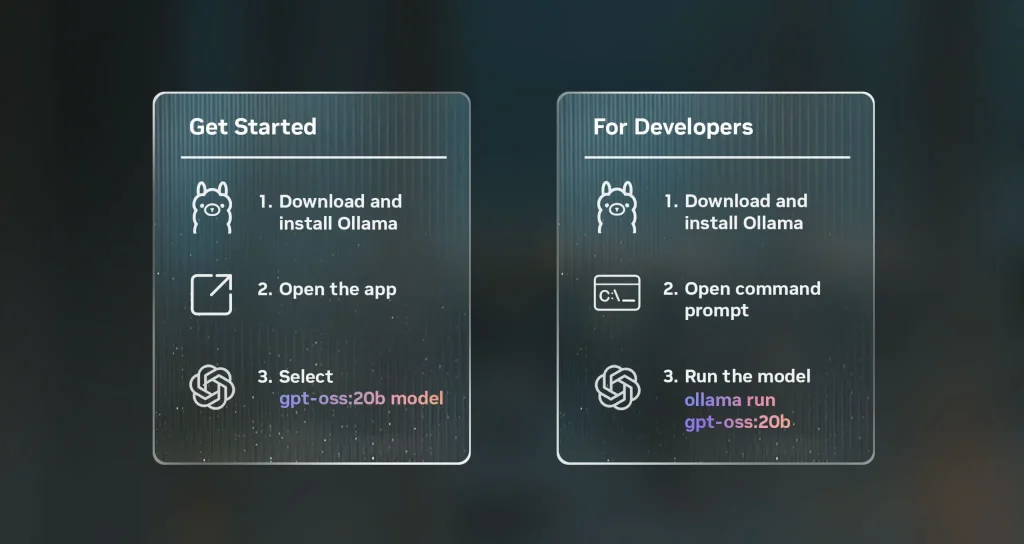

- Ollama: Tải xuống từ ollama.com.

- Tùy chọn: Docker để chạy Open WebUI hoặc Apidog để kiểm thử API.

- Internet: Kết nối ổn định để tải xuống mô hình ban đầu.

- Phụ thuộc: Trình điều khiển GPU NVIDIA/AMD nếu sử dụng tăng tốc GPU; chế độ chỉ CPU hoạt động nhưng chậm hơn.

Với những điều kiện này, bạn đã sẵn sàng cài đặt Ollama và triển khai GPT-OSS. Hãy chuyển sang quá trình cài đặt.

Tải mô hình gpt-oss ở đâu?

Link test và download mô hình này tại đây https://openai.com/open-models/. Bạn có thể thử trước khi tải về máy tính, hoặc nếu đang sử dụng Ollama thì có thể tải trực tiếp về máy tính thông qua terminal bằng lệnh:

ollama run gpt-oss:20bollama run gpt-oss:120b